Robots.txt

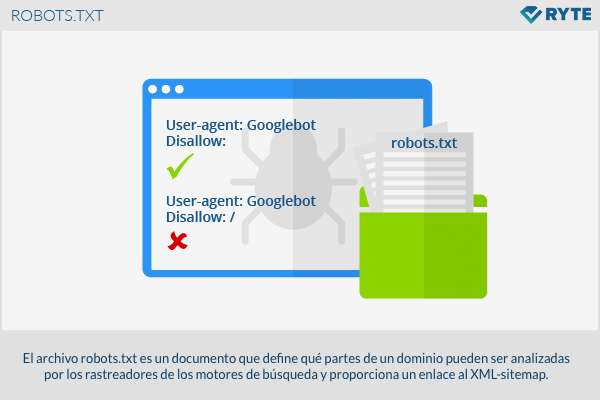

El archivo robots.txt es un documento que define qué partes de un dominio pueden ser analizadas por los rastreadores de los motores de búsqueda y proporciona un enlace al XML-sitemap.

Estructura

El llamado “Robots Exclusion Standard Protocol“, Protocolo Estándar de Exclusiones Robots, se publicó por primera vez en 1994. Este protocolo establece que los rastreadores de los motores de búsqueda deben buscar y leer el archivo llamado “robots.txt“ antes de empezar con la indexación. Es por esto que se debe colocar en el directorio raíz del dominio. Sin embargo, debemos recordar que no todos los rastreadores siguen esta misma norma y por lo tanto, los “robots.txt“ no aseguran al 100% protección de acceso y privacidad. Algunos motores de búsqueda todavía indexan las páginas bloqueadas y muestran incluso aquellas sin descripción en los SERPs. Esto ocurre particularmente con sitios web que contienen demasiados enlaces. Sin embargo, los motores de búsqueda más importantes como Google, Yahoo y Bing sí que se ajustan a las normas del protocolo “robots.txt“.

Creación y control del “robots.txt“

Es simple crear un “robots.txt“ con la ayuda de un editor de textos. Además, puedes encontrar herramientas gratuitas en internet que ofrecen información detallada sobre cómo generar un archivo “robots.txt“ o que, incluso, te lo crean automáticamente. Cada archivo contiene 2 bloques. En el primero, se especifica para qué usuarios son válidas las instrucciones. En el segundo bloque se escriben las instrucciones, llamadas “disallow“, con la lista de las páginas que deben excluirse. Se recomienda comprobar con atención que el archivo se haya escrito correctamente antes de descargarlo en el directorio ya que, con simplemente un minúsculo error de sintaxis, se pueden malinterpretar las instrucciones e indexar páginas que, en teoría, no deberían salir en los resultados de búsqueda. Para verificar si el archivo “robots.txt“ funciona correctamente se puede utilizar la herramienta webmaster de Google y realizar un análisis en „status“ -> „blocked URLs“.

Exclusión de páginas

La estructura más simple de un archivo robots.txt aparece del siguiente modo:

User-agent: Googlebot Disallow:

Este código permite que Googlebot analice todas las páginas. Lo contrario, como por ejemplo la prohibición completa del sitio web, se escribe del siguiente modo: '

User-agent: Googlebot Disallow:

En la línea del “User-agent“ el usuario escribe para quién va dirigido. Pueden utilizarse los siguientes términos:

- Googlebot (Google search engine)

- Googlebot-Image (Google-image search)

- Adsbot-Google (Google AdWords)

- Slurp (Yahoo)

- bingbot (Bing)

Si la orden va dirigida a diferentes usuarios cada robot tendrá su línea propia. En mindshape.de podrás encontrar un resumen de las órdenes y parámetros más comunes para la creación de un robots.txt. También se puede añadir un enlace a un XML-Sitemap del siguiente modo:

Sitemap: http://www.domain.de/sitemap.xm

Ejemplo

# robots.txt for http://www.example.com/ User-agent: UniversalRobot/1.0 User-agent: my-robot Disallow: /sources/dtd/ User-agent: * Disallow: /nonsense/ Disallow: /temp/ Disallow: /newsticker.shtml

Relevancia para el SEO

El uso del protocolo robots.txt influye en el acceso de los rastreadores al sitio web. Existen dos comandos diferentes: "allow" y "disallow". Es muy importante utilizar correctamente este protocolo ya que si el webmaster bloquea por error - a través de la orden "disallow" - archivos y contenidos importantes del sitio web los rastreadores no serán capaces de leerlo ni indexarlo. Sin embargo, si se utiliza correctamente los webmasters son capaces de informar a los rastreadores de cómo analizar la estructura interna de su sitio web.

Enlaces web

- Información sobre los archivos robots.txt support.google.com

- Archivo robots.txt: Qué es, para qué sirve y cómo crearlo Blog ignaciosantiago.com